2024プライムデーを経てアップデートされたので、現在のデスク環境をまとめてみる。多分毎年やる。

勤務・ワークアウト量

- 週1通勤、4リモートをベースに客先やイベント次第で前後

- 現在は育休中

- Zwift週2~3

見た目よりも実用性に振って構築。特に音声や入力IFは若干の遅延が気になってしまう方なので、有線接続を残している。 WEB会議がメインなので、安定性と低遅延のため有線LANのインターネット環境がマスト。

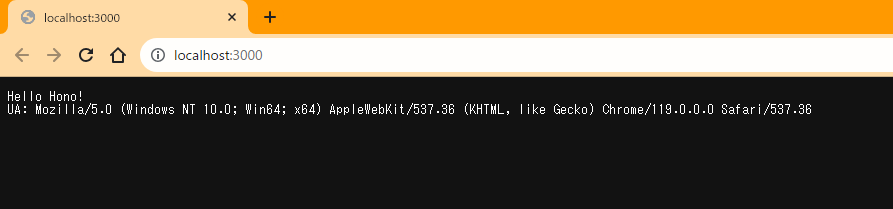

外観

34インチウルトラワイドモニタ+ノートPC画面のスタイルに落ち着いた。

プライベートのThinkPad T14sと仕事用のMacbook Pro(M1)で周辺機器をほぼ全て共用。地味に機器数が多く、有線LANも必要なのでHPのThunderbolt3ハブ経由ですべてのアクセサリを切り替える運用。

寝室が近く、明かりも声も気を遣う場合があるので、BenQのモニターライトが作業灯がわり。

Zwiftスタイル

エルゴトロンLXモニターアームをフルに使って、外部モニタをローラー前に移動。ローラー中の音声出力はもっぱらOpenRun Proを使って聞いている。ワークアウト中でも聞こえる音量だとリビングに響いてうるさいと指摘を受けたため…

部屋に設置されているダイキンのエアコンがサーキュレーター兼用タイプなので工業扇がなくとも十分な風量を確保できている。

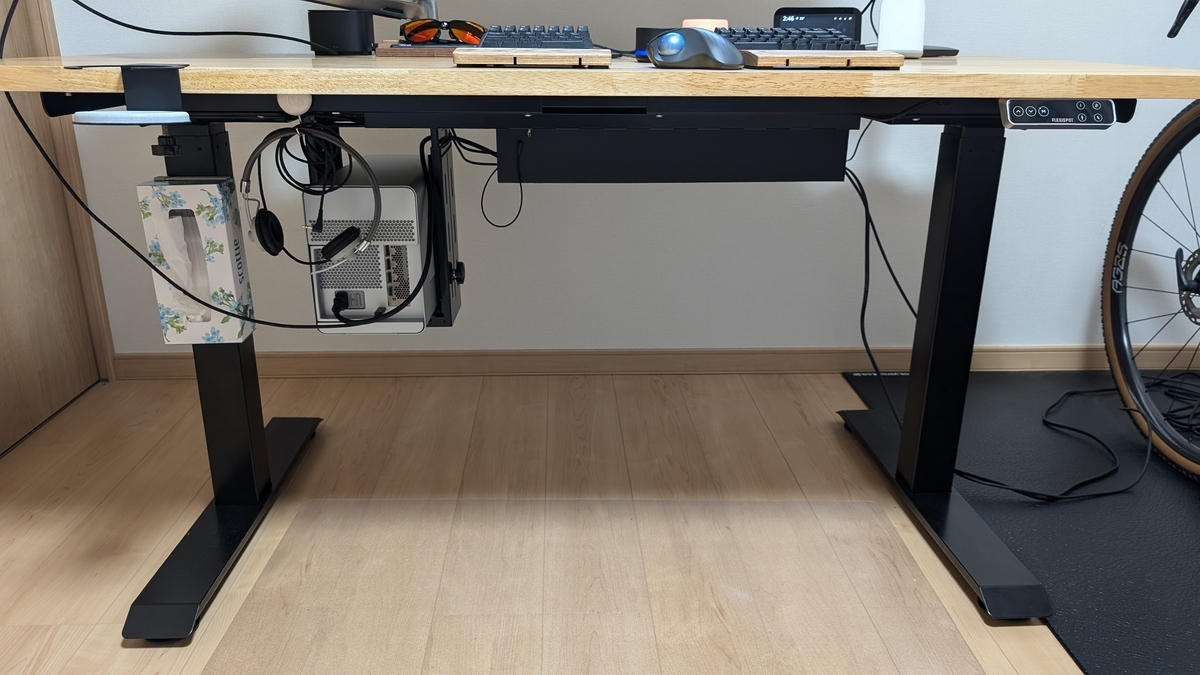

大物

Flexispot EJ2

リモートワーク中期に購入した昇降デスク。天板はマルトクショップのオーダー品。当時は純正天板に望みのサイズ(140x70)が無かったが、今なら純正竹天板でも良いかなと思える。

天板の磨きやオイル加工については作成当時の記事に書き留めている。

gensobunya-tech.hatenablog.com

ただ、今となっては、E7やE7Hのようなハイグレードを選んでいればよかったと思っている。

EJ2は最低高がそこまで低くないが、椅子のシルフィーと合わせて、店頭で肘置きと天板がほぼツライチになることを確認していた。ただ、裸足で座った際は、靴を履いて座った時より数センチ低いほうがしっくりくるということに気づけなかった。

※EJ2の最低高が69cmに対して、E7シリーズは58cm。

Flexispot CH1 + Razar Core X + RTX 4070

プライベートPCに接続するeGPUキット。机の上はスッキリさせたかったので、Flexispot CH1を使ってデスク下に吊り下げ。

本来はタワーPCをセットするためのキットで、高さがあっていないがそれなりに安定して固定できるのでeGPUボックスでも続投させた。ケースを90度回転させることができるので、取り付け後にケーブルを抜き差しするのも楽。専用品なのに天板にねじ止めという点を除けばよくできている。

gensobunya-tech.hatenablog.com

TB3ハブ経由でデイジーチェーン接続することも可能だったが、電力消費や接続安定性・TB3帯域の消費も鑑みて、2ポートあるT14sのThunderbolt4端子に直接接続。、Zwiftや動画エンコードするときだけ繋いで利用している。

デイジーチェーン運用していた時期もあったが、認識したりしなかったりが煩わしかった。

オカモト シルフィー

定番なので書くことがない。ヘッドレストがあるとShokzの骨伝導イヤホンが使いづらいので無しのモデルを選んだくらいか。

入力IF系

キーボード・トラックボール

肩凝り解消に分割キーボードは効いた。トラックボールは定番のM575を中央に置いて満足しているが、最近はもっとポジションを動かさずに済む方法はないかと考えているところ。

ペンタブ

プレゼンでスライドに書き込む用。顔をカメラに向けたままにできるので、板タブ派。

整理整頓系

山崎実業 デスク下 天板ケーブルラック ロング

2024年の新顔。これまでは、ハブやディスプレイの巨大なACアダプタを飲み込みつつ、モニターアームと干渉しない直付けケーブルラックを探せずにいた。

PCに接続しないが電源は食うデバイス(Pixel Standなど)もあって、口数の多い電源タップが必須だったこともあり、拡張性と放熱性を考えてワイヤーラックに結束バンド留めをして、モニターアームクランプの穴に吊り下げていたのがこれまでのスタイル。柔軟性は高かったが見た目は捨てていた。

高さと容量、ケーブル出口の柔軟性を持ち、前面板を取り外せるこのケーブルラックのおかげで、配線が見えない形に再整理。アームクランプの位置も制限が外れ非常に使いやすくなった。

珪藻土コースター付きカップホルダー

2024年新顔。

溝を切ってあるコースターでも、張り付きからは逃れられなかったが、これで完全に解決。

机の上に水滴がついたり、こぼしたりする事故も防げてお得だった。

ケーブル整頓

ハブやeGPUにつないでいる着脱が頻繁なThunderboltケーブルはマグネット付きでノートPCトレイに貼り付け。

それ以外の配線を整理するだけのケーブルクリップと使い分けている。ゆくゆくはケーブルダクトなんかも使って、電源タップとLANケーブルもスッキリ隠したいところ。

ティッシュボックス

昇降デスクの脚にマグネットで装着するタイプのホルダー。

普段は目に入らないところなので、最低限のホールド機能だけをもった山崎実業製品を。

まとめ

生活に余裕が出てきたせいか、今年は見た目を改善するグッズが増えた。

モニタが5年ほど使っている古いものなので、そろそろハブと合わせて来年にも交換か…?

![BenQ ScreenBar スクリーンバー モニター掛け式ライト [デスクライト monitor lamp モニターライト] BenQ ScreenBar スクリーンバー モニター掛け式ライト [デスクライト monitor lamp モニターライト]](https://m.media-amazon.com/images/I/31l6z-WKqAL._SL500_.jpg)